استیون هاوکینگ دربارهی ترساش از هوش مصنوعی توضیح میدهد

هوش مصنوعی ماهر و توانا یکی از دغدغههای مهم استیون هاوکینگ است و مهارت بالای آنها خطر اصلی برای انسان محسوب میشود.

“خطر اصلی هوش مصنوعی شرارت و بدجنسی نیست، بلکه مهارت و توانایی است.”

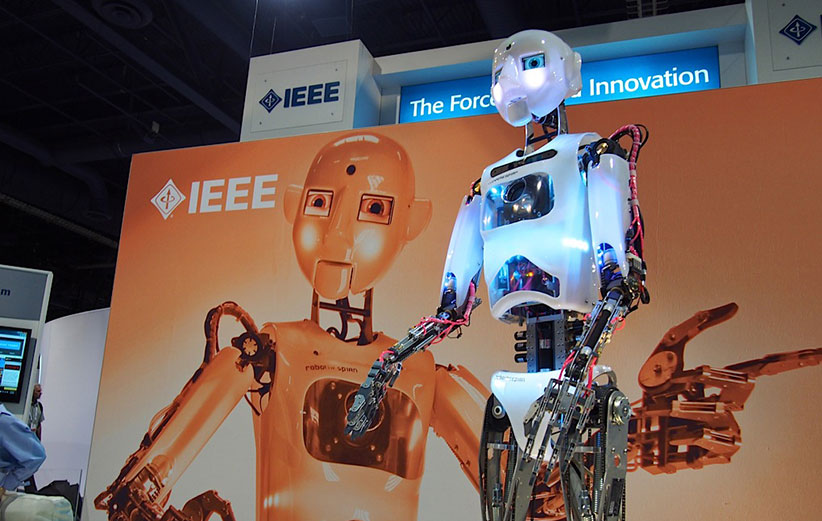

استیون هاوکینگ چند ماه پیش کاربران وبسایت «ردیت» Reddit را به یک جلسهی پرسش و پاسخ Ask Me Anything دعوت کرده بود. موضوع اصلی که در این AMA مورد بحث قرار گرفت به هوش مصنوعی مربوط میشد. حالا این جلسهی پرسش و پاسخ از سوی ردیت منتشر شده که هاوکینگ در آن موضعاش را در مقابل خطر هوش مصنوعی شفافسازی میکند. او در پاسخ به معلمی که از بحث دربارهی ترمیناتور با دانشآموزاناش خسته شده بود، گفت: “خطر اصلی هوش مصنوعی شرارت و بدجنسی نیست، بلکه مهارت و توانایی است.” او توضیح داد که روباتهای قاتل یا پلید خطر اصلی نیستند. “یک هوش مصنوعی بسیار باهوش در انجام کارها و دستیابی به اهدافاش مهارت خارقالعادهای دارد و اگر آن اهداف با خواستههای ما هماهنگی نداشته باشد، به دردسر خواهیم افتاد.” هاوکینگ قبلا هم اشاره کرده بود که “هوش مصنوعی میتواند پایان نسل بشر را رقم بزند” و همراه با ایلان ماسک و دیگر افراد سرشناس در عرصهی فناوری، نامهای را برای تحریم سلاحهای مستقل امضا کرده بود.

البته استدلال استیون هاوکینگ به هیچ وجه دلگرمکننده نیست؛ یک ایراد نرمافزاری در هوش مصنوعی میتواند تبعات خطرناکی برای جهان داشته باشد. هاوکینگ اضافه کرد: “مثلا شما از مورچه بدتان نمیآید و از روی عمد و بدخواهی پایتان را روی آن نمیگذارید. اما اگر مسوول یک پروژهی انرژی سبز هیدروالکتریک باشید، برایتان فرقی نمیکند که لونهی مورچه در مسیر آب قرار داشته باشد. ما نباید اجازه بدهیم که بشر در جایگاه آن مورچهها قرار بگیرد.” به همین دلیل است که هاوکینگ و دیگران اصرار دارند که انسانها باید هوش مصنوعی را تحت کنترل داشته باشند.

منبع: Reddit

به نظر من اینا فقط رویا (کابوس) پردازیه، هوش مصنوعی هرگز توانایی یک انسان نرمال رو بدست نمیاره.

اول به دلیل نداشتن محل ذخیره سازی اطلاعات مستقل و سبک. کافیه به سرورهای هوش های مصنوعی نگاه کنید. فضاهای ابری یا فضاهایی به اندازه یک انباری بزرگ رو به خودشون اختصاص دادن. فکر کن مغزت در چندین گوشه از دنیا پراکنده باشه کافیه یه تیکش از مدار خارج بشه (همون فضای ابری) قطعا ضربه بزرگی به هوش فرد میخوره و همین ثابت بودن مکان به شدت اونو آسیب پذیر میکنه، گیرم که یک هوش مصنوعی که در یک فضای مشخص قرار داره اونقدر قوی بشه که از انسان پیشی بگیره، خب که چی؟ اون هنوزم مثل یک درخت به زمین چسبیده و ما خداروشکر (حداقل در این مورد) سلاح لازم برای از بین بردنشو داریم. پس عدم تحرک و مغز گنده! ضعف بسیار بزرگیه برای این موجوده.

و دلیل دوم منبع تغذیه این هوش مصنوعیه، انسان اگر ناچار بشه میتونه علف هم بخوره اما نابغه ما فقط یک چیز مصرف میکنه، الکتریسیته، کافیه منبع تغذیه رو ازش جدا کنین، میشه چند تکه فلز و پلاستیک بی مصرف.

شاید بگین همچین هوشی راه های دفاع از خودشو میسازه، اولا این در این صورته که حس ترس رو هم داشته باشه، که من واقعا نمیدونم چطوری قراره این حس رو در هوش مصنوعی ساخت!!! چون اگر نترسه به فکر دفاع هم نمی افته. دوم اگر هم بترسه و برای خودش راه کارهای دفاعی خلق کنه، بعید میدونم شانسی در مقابل بزرگترین مهاجمین تاریخ خلقت داشته باشه. باز هم همه اینها در صورتیه که دلیلی برای برتری جویی با انسان داشته باشه که من واقعن دلیلشو نمیدونم. بماند که چطور قراره این حس برتری جویی رو درش به وجود بیاریم

جدای از این حرف های علمی تخیلی… هوش مصنوعی هنوز نمیتونه یک دست خط کج و کوله رو تشخیص بده. درحالی که همون دست خط برای چندمیلیارد انسان قابل تشخیصه.

به نظر من شما اشتباه میکنید یک چیزی که هیچ وقت نمی ایستد پیشرفت علم است که هر لحظه سرعتش بیشتر میشود و با پیش رفت علم مطمئنا یک روزی هرچیزی که امروز بهش میگیم غیر ممکن ممکن میشود و یک ربات با هوش مصنوعی با قدرت هوش انسان و یا قوی تر ساخته میشود ولی بدی هایی هم دارد فکر کنیم که هکر ها سیستم یک ربات را هک کنند یک تروریست به وجود می آید

من هم فکر میکنم شما اصلا متوجه نشدی من چی گفتم.

هرکر بدبختم باز شد آدم بده 😀

بیخیال.

bijan جان خیلی ممنون به این میگن اثبات با دلایل منطقی خوشم اومد واقعا که خوب بود

ربات ها حتی اگه این مشکلات رو نداشته بودن هم بازم نمی تونن خلاقیت و نو آوری انسان رو تقلید کنند

ترمیناتور…

چه جالب..

فقط یه جیمز باند کم داریم..

خداییش دستاورد ترسناکیه ولی این دلیل نمیشه به پیشرفت فکر نکنیم اگر قرار باشه به فناوری هوش مصنوعی برسیم باید خودمون را اون قدر قوی بکنیم که بتونیم کنترلش کنیم

کلا هاوکینگ از دو تا چیز واهمه داره یکی هوش مصنوعی و اون یکی هم بیگانگان فضایی دانشمندان را هم از تحقیق در مورد این دو بر حذر داشته

ولی من با حرفش در مورد انقراض بشر موافقم من فکر کنم نابودیمون بدست خودمون حالا یا با هوش مصنوعی ، جنگ و یا بیماری و این قانون نا نوشته تاریخچه زمینه

تبله تقریبا ایشون درست گفته در واقع باید هوش مصنوعی در اختیار انسان باشه و به اون کمک نه نه ما به اونها به هر حال امکان داره خطراتی داشته باشن

منم موافقم دنیایی بدون انسان

چه بهتر دنیایی بدون انسان ها