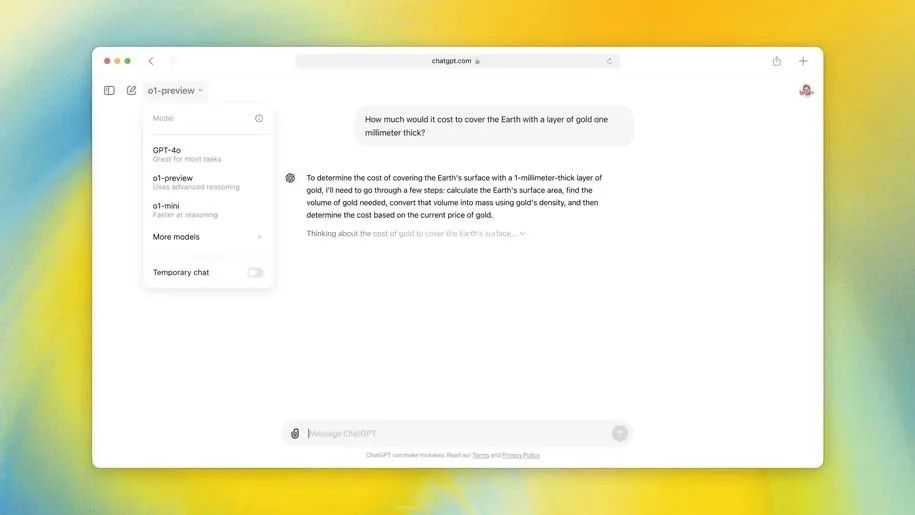

OpenAI از مدل هوش مصنوعی O1 رونمایی کرد؛ اولین مدل با قدرت استدلال

شرکت OpenAI از مدل جدیدی به نام O1 رونمایی میکند. این مدل، اولین مدل در مجموعهای برنامهریزیشده از مدلهای «استدلالگر» است که برای پاسخگویی به سوالات پیچیدهتر و سریعتر از انسان آموزش دیدهاند. این مدل در کنار O1-mini، نسخهای کوچکتر و ارزانتر، منتشر میشود. و بله، اگر از شایعات هوش مصنوعی باخبر هستید: این در واقع همان مدل Strawberry بسیار جنجالی است.

برای OpenAI، مدل O1 گامی به سوی هدف گستردهتر آن یعنی هوش مصنوعی شبیه انسان است. از نظر کاربردی، این مدل در نوشتن کد و حل مسائل چندمرحلهای بهتر از مدلهای قبلی عمل میکند. اما در عین حال، استفاده از آن نسبت به GPT-4o گرانتر و کندتر است. OpenAI این نسخه از O1 را «پیشنمایش» مینامد تا بر نوپا بودن آن تأکید کند.

کاربران ChatGPT Plus و Team از امروز به O1-preview و O1-mini دسترسی خواهند داشت، در حالی که کاربران Enterprise و Edu اوایل هفتهی آینده به آن دسترسی پیدا میکنند. OpenAI میگوید قصد دارد دسترسی به O1-mini را برای همهی کاربران رایگان ChatGPT فراهم کند، اما هنوز تاریخ انتشار آن را مشخص نکرده است. دسترسی توسعهدهندگان به O1 بسیار گران است: در API، O1-preview به ازای هر 1 میلیون توکن ورودی (یا بخشهایی از متن که توسط مدل تجزیه میشود) 15 دلار و به ازای هر 1 میلیون توکن خروجی 60 دلار هزینه دارد. برای مقایسه، GPT-4o به ازای هر 1 میلیون توکن ورودی 5 دلار و به ازای هر 1 میلیون توکن خروجی 15 دلار هزینه دارد.

جری تورک، سرپرست تحقیقات OpenAI، گفته که آموزش مدل O1 اساساً با مدلهای قبلی متفاوت است، اگرچه این شرکت در مورد جزئیات دقیق آن مبهم صحبت میکند. او میگوید O1 «با استفاده از یک الگوریتم بهینهسازی کاملاً جدید و یک مجموعه دادهی آموزشی جدید که مخصوص آن طراحی شده، آموزش دیده است».

OpenAI مدلهای GPT قبلی را برای تقلید از الگوهای موجود در دادههای آموزشی خود آموزش داده بود. با O1، این شرکت مدل را برای حل مسائل به تنهایی با استفاده از تکنیکی به نام یادگیری تقویتی آموزش داده است که سیستم را از طریق پاداشها و جریمهها آموزش میدهد. سپس از یک «زنجیره تفکر» برای پردازش پرسشها استفاده میکند، مشابه نحوهی پردازش مسائل توسط انسانها که گام به گام پیش میروند.

OpenAI میگوید که در نتیجهی این روش جدید آموزشی، مدل باید دقیقتر باشد. تورک میگوید: «ما متوجه شدهایم که این مدل کمتر دچار توهم میشود». اما این مشکل همچنان وجود دارد. «نمیتوانیم بگوییم که توهم را حل کردهایم».

به گفتهی OpenAI، نکتهی اصلی که این مدل جدید را از GPT-4o متمایز میکند، توانایی آن در حل مسائل پیچیده، مانند کدنویسی و ریاضیات و در عین حال توضیح استدلال خود است. باب مکگرو، مدیر ارشد تحقیقات OpenAI، گفته: «این مدل قطعاً در حل آزمون ریاضی AP از من بهتر است و من در دانشگاه در رشتهی ریاضی تحصیل کردهام». او میگوید OpenAI همچنین O1 را در برابر آزمون ورودی المپیاد بینالمللی ریاضی آزمایش کرده است و در حالی که GPT-4o فقط 13 درصد از مسائل را به درستی حل کرده، O1 به امتیاز 83 درصد رسیده است.

در مسابقات برنامهنویسی آنلاین که به عنوان مسابقات Codeforces شناخته میشوند، این مدل جدید به صدک 89 شرکتکنندگان رسیده است و OpenAI ادعا میکند که بهروزرسانی بعدی این مدل «مشابه دانشجویان دکترا در انجام وظایف چالشبرانگیز در فیزیک، شیمی و زیستشناسی» عمل خواهد کرد.

در عین حال، O1 در بسیاری از زمینهها به اندازهی GPT-4o توانمند نیست. در دانش واقعی در مورد جهان به خوبی عمل نمیکند. همچنین قابلیت مرور وب یا پردازش فایلها و تصاویر را ندارد. با این حال، این شرکت معتقد است که این مدل نشاندهندهی طبقهبندی کاملاً جدیدی از قابلیتها است. اما این مدل فکر نمیکند و مطمئناً انسان نیست. پس چرا طوری طراحی شده که به نظر برسد فکر میکند؟

به گفتهی تورک، OpenAI به معادلسازی تفکر مدل هوش مصنوعی با تفکر انسان اعتقاد ندارد. اما هدف این رابط کاربری نشان دادن این است که چگونه مدل زمان بیشتری را صرف پردازش و عمیقتر شدن در حل مسائل میکند. او میگوید: «راههایی وجود دارد که در آنها این مدل نسبت به مدلهای قبلی انسانیتر به نظر میرسد».

حرکت به سمت ایجنتها

مدلهای زبان بزرگ به شکلی که امروزه وجود دارند، دقیقاً آنقدرها هوشمند نیستند. آنها در اصل فقط توالی کلمات را پیشبینی میکنند تا بر اساس الگوهای آموختهشده از حجم وسیعی از دادهها به شما پاسخی بدهند. به عنوان مثال، ChatGPT که تمایل دارد به اشتباه ادعا کند که کلمه «strawberry» فقط دو حرف R دارد زیرا کلمه را به درستی تجزیه نمیکند. به هر حال، مدل جدید O1 این پرسش را به درستی پاسخ داد.

از آنجایی که طبق گزارشها، OpenAI به دنبال جذب سرمایه بیشتر با ارزشگذاری خیرهکنندهی 150 میلیارد دلار است، حرکت رو به جلوی آن به پیشرفتهای تحقیقاتی بیشتر وابسته است. این شرکت قابلیتهای استدلال را به مدلهای زبان بزرگ (LLM) اضافه میکند زیرا آیندهای را با سیستمهای خودکار یا ایجنتهایی میبیند که قادر به تصمیمگیری و انجام اقدامات از طرف شما هستند.

برای محققان هوش مصنوعی، شکستن استدلال گام بعدی مهمی به سوی هوش در سطح انسان است. گفته میشود اگر مدلی قادر به انجام کارهای بیشتری از تشخیص الگو باشد، میتواند منجر به پیشرفت در زمینههایی مانند پزشکی و مهندسی شود. با این حال، در حال حاضر، قابلیتهای استدلال O1 نسبتاً کند است، شبیه به ایجنتها نیست و استفاده از آن برای توسعهدهندگان گران است.

مکگرو میگوید: «ما ماههاست که روی استدلال کار میکنیم زیرا فکر میکنیم این در واقع یک موفقیت حیاتی است. اساساً، این یک روش جدید برای مدلها است تا بتوانند مسائل واقعاً سختی را که برای پیشرفت به سوی سطوح هوش انسانی لازم است، حل کنند».

منبع: The Verge