چگونه هوش مصنوعی را دموکراتیکتر کنیم؟

در دنیایی که به سمت توسعهی سامانههای هوش مصنوعی عظیم و توسط دانشگاههای برتر میرود، چگونه میتوان با ساخت مدلهای هوشمند کوچکتر، توسعهی فناوری را دردسترس پژوهشگران بیشتری قرار داد و آن را بیشتر دموکراتیک کرد؟

«تبدیلگر از پیش آموزش دیدهی مولد» (Generative Pre-trained Transformer) یا بهطور خلاصه «جیپیتی-3» (GPT-3) یک مدل زبانی بزرگ که قادر به درک متن، پاسخ به پرسشها و ایجاد نمونههای نوشتاری جدید است، توجه رسانههای بینالمللی را به خود جلب کرده است.

این مدل گسترده و بزرگ که توسط «اوپنایآی» (OpenAI) یک سازمان غیرانتفاعی مستقر در کالیفرنیا و سازندهی سیستمهای هوش مصنوعی همهمنظوره، عرضه شده است، توانایی چشمگیری در تقلید از نوشتههای انسانها را دارد و حتی سال گذشته بدون کمک انسان مقالهای دربارهی صلح رباتها با انسانها نوشت. اما چیزی که قابل توجه است دقیقا همین اندازهی عظیم آن است.

برای ساخت چنین مدل هوشمندی و نوآوری، پژوهشگران 175 میلیارد پارامتر (نوعی واحد محاسباتی) و بیش از 45 ترابایت متن را از «ویکیپدیا» (Wikipedia)، «ردیت» (Reddit)، «کامان کراول» (Common Crawl) و منابع دیگر جمعآوری کردند و سپس آنها را در فرآیندی که صدها واحد پردازشی را برای هزاران ساعت اشغال کرد، آموزش دادند.

اما GPT-3 تنها خودش قابل بررسی نیست، بلکه یک تمایل گستردهتر در حوزهی هوش مصنوعی را نشان میدهد. «یادگیری عمیق» (Deep Learning) که در سالهای اخیر به تکنیک غالب برای ایجاد هوش مصنوعی تبدیل شده است، از حجم عظیمی از دادهها و قدرت محاسباتی برای تأمین مدلهای پیچیده و دقیق استفاده میکند. اما این منابع بیشتر برای پژوهشگران در شرکتهای بزرگ و دانشگاههای برتر قابل دسترسی است.

در نتیجه مطالعهای از دانشگاه وسترن نشان میدهد که «دموکراسیزدایی» (De-Democratization) در هوش مصنوعی رخ داده است؛ تعداد پژوهشگرانی که میتوانند به پیشرفتهای لبهی فناوری کمک کنند در حال کاهش است. این امر مجموعه افرادی که قادر به تعریف زمینههای تحقیقاتی برای این فناوری محوری هستند را محدود میکند و پیامدهای اجتماعی هم به دنبال خواهد داشت. حتی ممکن است باعث تشدید برخی از چالشهای اخلاقی پیش روی توسعهی هوش مصنوعی، ازجمله تجاوز به حریم خصوصی، جانبداری و اثرات زیستمحیطی در مدلهای بزرگ شود.

برای مبارزه با این مشکلات، پژوهشگران در تلاشند تا دریابند که چگونه میتوانند کارهای بیشتری را با ابزارهای دردسترس کمتر انجام دهند. در این زمینه یکی از پیشرفتهای اخیر، یادگیری «کمتر از یک» مرحلهای (Less-than-One) یا «لو-شات» (LO-Shot) نام دارد که توسط «ایلیا سوچولوتسکی» (Ilia Sucholutsky) و «ماتیاس شونلانو» (Matthias Schonlau) از دانشگاه واترلو توسعه یافته است.

اصل پشت یادگیری لو-شات این است که یک هوش مصنوعی باید دربارهی اشیا موجود در جهان بیاموزد، بدون اینکه نمونهای از هر یک به او داده شود. تاکنون این یک مانع بزرگ برای سیستمهای هوش مصنوعی معاصر بوده است که اغلب به هزاران مثال برای یادگیری تشخیص اشیا نیاز دارند.

این در حالی است که انسانها اغلب میتوانند از نمونههای موجود، تجسمی ذهنی و تصویری انتزاعی داشته باشند تا چیزهای جدیدی را که قبلا دیده نشدهاند، تشخیص دهند. برای نمونه هنگامی که اشکال مختلف نشان داده میشود، کودک میتواند به آسانی میان مثالها تمایز قائل شود و روابط میان آنچه نشان داده شده و شکلهای تازه را تشخیص دهد.

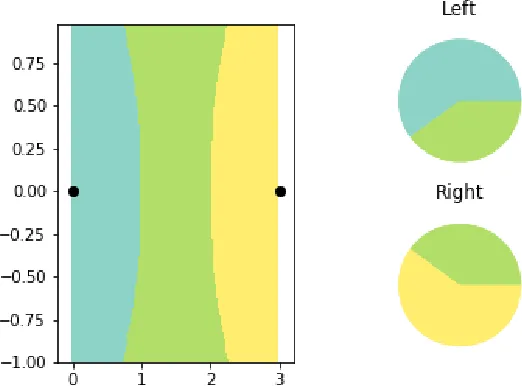

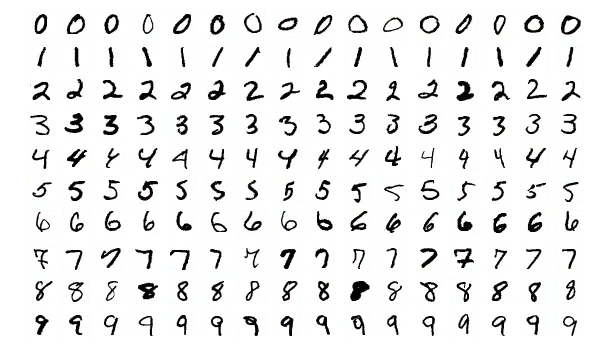

برای پیش بردن این نوع یادگیری، تیم دانشگاه واترلو ابتدا آن را از طریق فرآیندی به نام «تقطیر نرم» (Soft Distillation) معرفی کرد. یک پایگاه دادهی تصویری با نام MNIST که توسط مؤسسهی ملی فناوری و استانداردها در آمریکا نگهداری میشود و شامل 6000 نمونه از ارقام نوشته شده از 0 تا 9 است، به پنج تصویر که ویژگیهای اعداد را با هم ترکیب میکردند، کاهش یافت. پس از نمایش تنها همان پنج نمونه، سیستم دانشگاه واترلو توانست 92 درصد از تصاویر باقیمانده در پایگاه داده را با دقت طبقهبندی کند.

این تیم در یکی از تازهترین مقالات خود این اصل را گسترش داد تا نشان دهد که از نظر تئوری، تکنیکهای «لو-شات» (LO-Shot) به هوش مصنوعی اجازه میدهد تا بهطور بالقوه بیاموزد که هزاران شیء جدید را با مجموعه دادههای کوچک، برای نمونه حتی دو مثال تشخیص دهد. این یک پیشرفت بزرگ در سیستمهای یادگیری عمیق کلاسیک سنتی است که در آن تقاضا برای دادهها با نیاز به تمایز اشیا بیشتر بهطور تصاعدی افزایش مییابد.

هماکنون مجموعه دادههای اندک لو-شات باید بهدقت مهندسی شود تا ویژگیهای کلاسهای گوناگون اشیا را دربر بگیرد، اما سوچولوتسکی با نگاه به روابط میان اشیایی که قبلا در مجموعه دادههای کوچک موجود ثبت شدهاند، بهدنبال توسعهی بیشتر این کار است.

اجازه دادن به هوش مصنوعی برای یادگیری با دادههای کمتر به چند دلیل مهم است. نخست اینکه با وادار کردن سیستم به تعمیم آگاهی خود به طبقهبندیهایی که ندیده است، فرآیند واقعی یادگیری را بهتر شامل میشود. همچنین این تکنیک با ایجاد تجسمهای ذهنی و انتزاعی که روابط بین اشیا را به تصویر میکشد، پتانسیل جانبداری را هم کاهش میدهد.

هماکنون سیستمهای یادگیری عمیق قربانی جانبداری ناشی از ویژگیهای نامربوط در دادههایی میشوند که برای آموزش استفاده میکنند. یک نمونهی شناخته شده از این مشکل این است که هوش مصنوعی، سگها را هنگامی که تصاویری از آنها در یک محیط برفی نشان داده شود، بهعنوان گرگ طبقهبندی میکند، زیرا اکثر تصاویر گرگها، آنها را در میان برف نشان میدهد. توانایی صفر کردن جنبههای مرتبط تصویر به جلوگیری از این اشتباهات کمک میکند. بنابراین کاهش نیاز به دادههای متنوع، این سیستمها را کمتر در معرض چنین سوگیریهایی قرار میدهد.

در گام بعدی، هر چه دادههای لازم برای استفاده کمتر باشد، انگیزهی کمتری برای نظارت بر افراد برای ساخت الگوریتمهای بهتر وجود دارد. برای نمونه تکنیکهای تقطیر نرم، هماکنون بر تحقیقات هوش مصنوعی پزشکی که مدلهای خود را با استفاده از اطلاعات حساس سلامت آموزش میدهند، تأثیر گذاشته است. در یک مقالهی اخیر، پژوهشگران از تقطیر نرم در تصاویر تشخیصی پرتو ایکس بر اساس یک مجموعه دادهی کوچک و اصل حفظ حریم خصوصی استفاده کردند.

در نهایت اجازه دادن به هوش مصنوعی برای یادگیری با استفاده از دادههای کمتر به دموکراتیک کردن این حوزه کمک میکند. با هوش مصنوعی کوچکتر، دانشگاهها میتوانند در ارتباط با این حوزه باقی بمانند و از خطر استفادهی بسیار از برخی اساتید برتر، توسط صنعت جلوگیری شود.

نه تنها یادگیری لو-شات موانع ورود را با کاهش هزینههای آموزشی و کاهش نیازهای دادهای، کم میکند، بلکه انعطافپذیری بیشتری را برای کاربران در ایجاد مجموعههای جدید و آزمایشهایی با رویکردهای تازه فراهم میکند.

همچنین با کاهش زمان صرف شده برای مهندسی دادهها و معماری، پژوهشگرانی که به دنبال استفاده از هوش مصنوعی هستند، میتوانند زمان بیشتری را صرف تمرکز بر مشکلات عملی کنند که قصد حل آنها را دارند.

عکس کاور: طرحی گرافیکی دربارهی هوش مصنوعی

Credit: Getty Images

منبع: Scientific America